“AI: usiamola a salvaguardia dei diritti umani”

Floriano Zini, tecnologo accademico della Smart Data Factory della Facoltà di Scienze e Tecnologie informatiche al NOI Techpark, è un esperto di e-health, dove spesso applica tecniche di Intelligenza Artificiale (IA) Non esplora l’IA esclusivamente per ragioni professionali: le motivazioni etiche sono sempre presenti nel suo lavoro. Oltre ad essere un ricercatore e occuparsi di come trasferire la ricerca della Facoltà in collaborazioni con aziende, pubblica amministrazione e attori del terzo settore, Zini è anche attivista di Amnesty International. È il responsabile della circoscrizione Veneto e Trentino - Alto Adige della ong. Con Amnesty ha collaborato per la realizzazione dell’iniziativa Barometro dell’Odio, con cui sono stati monitorati i discorsi d’odio sui social durante le campagne elettorali in Italia degli ultimi anni. A lui abbiamo chiesto se l’allerta relativa ai pericoli rappresentati dall’impiego dell’Intelligenza Artificiale (IA) ai fini di sorveglianza e repressione sia giustificata e quali possibili positivi impieghi della tecnologia possano essere valorizzati a tutela dei diritti umani.

Floriano Zini, quando inizia la sua storia come attivista dei diritti umani?

Ho cominciato ad occuparmi di diritti umani più di vent’anni fa, all’epoca dei fatti del G8 di Genova, nel 2001. All’epoca, quello che avvenne nella scuola Diaz venne descritto da Amnesty International come “la più grave violazione di diritti umani in un paese democratico dal dopoguerra”. Dentro di me pensai: “Se succedono cose del genere da noi, figuriamoci in Paesi meno democratici e con meno tutele”. Ero già socio di Amnesty e decisi di diventare attivista, cioè di prestare il mio tempo libero come volontario e cominciai a fare promozione delle tematiche e campagne di Amnesty nel territorio in cui vivevo.

L’impiego delle nuove tecnologie della sorveglianza e del controllo che sfruttano l’IA, pongono problemi in relazione a diversi ambiti: dalle migrazioni ai media, all’ordine pubblico. Quali ritiene gli aspetti più preoccupanti a cui come società democratica dovremmo prestare maggiore attenzione?

Sono convinto che si debba effettuare una distinzione tra i titoli della stampa generalista e quella che è la realtà dei fatti. Ogni giorno, o quasi, possiamo leggere articoli che ci avvertono della minacciosità degli algoritmi che potrebbero soggiogare la società. Ci vedo grande esagerazione. Forse ciò è dovuto al fatto che ancora si sa poco di cosa sia realmente l’intelligenza artificiale e dele possibilità che ci può regalare. Evocare scenari alla “Terminator”, in cui le macchine prevalgono sulla volontà umana, non è attuale, almeno non al momento e la possibilità che ci scappi di mano è abbastanza remota. È invece l’uso che facciamo noi esseri umani di algoritmi di IA – es. sistemi di videosorveglianza che permettono di riconoscere persone in mezzo a una folla – ad essere meritevole di una riflessione serie. Ci sono algoritmi che profilano etnicamente le persone e le categorizzano come più o meno pericolose. Recentemente si parla tanto di droni o macchine da guerra automatiche. Questi sono effettivamente dei pericoli, in quanto portano morte e distruzione e andrebbero regolati. In sintesi: bisogna vigilare su diversi aspetti ma il mondo in cui comanderanno i computer è lontano.

La Dichiarazione universale dei diritti umani è del 1946, un’epoca per così dire analogica. Ritiene che dovrebbe essere aggiornata, ridisegnandola per adattarla ai cambiamenti della nostra epoca?

Io credo che la Dichiarazione, nella sua essenza, in realtà sia molto attuale. I principi che sancisce potrebbero essere certamente intaccati da un uso errato delle tecnologie informatiche. È necessario calare gli articoli del ’48 nella nuova realtà. Direi: non cambiamola ma teniamone conto anche quando si parla di IA.

Ho una formazione scientifica, sono un informatico e credo fermamente che l’IA possa darci grandi opportunità per la difesa dei diritti umani. Va tenuta sotto controllo senza dimenticarci delle problematiche che sono connesse.

Gli effetti dello sviluppo dell’IA sulla società e sull’economia e delle minacce che tale sviluppo comporta, anche in relazione al rispetto dei diritti umani, sono oggetto di dibattito pubblico. Nella comunità accademica quanto tale tematica forma oggetto di un dibattito?

Se ne parla parecchio nella comunità accademica di area giuridica, ma anche gli informatici cominciano a prestarvi più attenzione e a farsi delle domande. Soprattutto ci si sta interrogando anche dal punto di vista tecnico come potrebbe essere possibile modificare gli algoritmi per renderli meno “pericolosi”.

Ci può parlare del Manifesto per l’Umanesimo digitale?

È un’iniziativa del prof. Hannes Werthner della Technische Universität di Vienna. È un esempio degli sforzi degli scienziati informatici che stanno provando a elaborare dei principi cui tecnici e ricercatori possono rifarsi quando sviluppano algoritmi di intelligenza artificiale. Uno degli autori è il prof. Francesco Ricci di unibz. È un’ottima iniziativa perché esprime la visione degli scienziati digitali sulle problematiche di cui stiamo parlando.

Come attivista di Amnesty, qual è l’approccio della Ong verso le tecnologie digitali?

Amnesty da anni si è posta il problema della potenziale minaccia per i diritti umani delle innovazioni tecnologiche. Per questo ha creato Amnesty Tech, un laboratorio informatico cui collaborano esperti di ambito informatico e giuridico. Un esempio delle sue attività è l’applicazione di tecniche di intelligenza artificiale all’analisi di immagini satellitari per scoprire zone del Darfur colpite da bombardamenti indiscriminati. Ciò ha permesso di smascherare le azioni delle truppe governative nel corso di una guerra che va avanti da tantissimi anni. Ciò in maniera molto più efficace e sicura rispetto all’opzione di inviare qualcuno sul campo. O, ancora, ha fatto una ricerca sugli spyware, software maligni che vengono installati sui cellulari di attivisti per spiarli e controllarli. Amnesty Tech è riuscita a capire come erano stati istallati e quindi ha potuto aiutarli e proteggerne la vita.

L’IA ha molti lati oscuri ma non tutto è da buttare, sembra di capire.

Assolutamente. Io ho una formazione scientifica, sono un informatico e credo fermamente che l’IA possa darci grandi opportunità per la difesa dei diritti umani. Va tenuta sotto controllo senza dimenticarci delle problematiche che sono connesse. Io stesso ho collaborato a un’iniziativa di Amnesty Italia chiamata “Hate Barometer” o Barometro dell’Odio, che ha riguardato il linguaggio d’odio online in occasione delle campagne elettorali italiane degli ultimi anni. Assieme ad altri attivisti ed esperti di linguaggio d’odio abbiamo monitorato i profili di alcuni esponenti politici rilevanti grazie alla catalogazione dei commenti sui social, raggruppati secondo diverse categorie e gradazioni di linguaggio d’odio. Ciò ha portato alla scoperta di cose che si potevano già sapere ma è sempre meglio avere dati che li confermino. Ad esempio, a proposito di migranti o lo jus soli, c’è l’utilizzo di linguaggio d’odio molto forte. Adesso abbiamo una grossa banca dati e, in futuro, si potrebbe pensare di mettere a punto algoritmi per il riconoscimento automatico di linguaggio d’odio ed effettuare un monitoraggio veloce e preciso.

Immagine di apertura: © Ivo Corrà

Related Articles

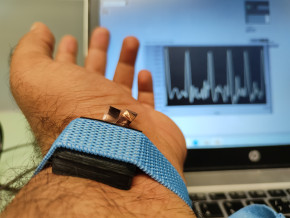

Tecno-prodotti. Creati nuovi sensori triboelettrici nel laboratorio di sensoristica al NOI Techpark

I wearable sono dispositivi ormai imprescindibili nel settore sanitario e sportivo: un mercato in crescita a livello globale che ha bisogno di fonti di energia alternative e sensori affidabili, economici e sostenibili. Il laboratorio Sensing Technologies Lab della Libera Università di Bolzano (unibz) al Parco Tecnologico NOI Techpark ha realizzato un prototipo di dispositivo indossabile autoalimentato che soddisfa tutti questi requisiti. Un progetto nato grazie alla collaborazione con il Center for Sensing Solutions di Eurac Research e l’Advanced Technology Institute dell’Università del Surrey.

unibz forscht an technologischen Lösungen zur Erhaltung des Permafrostes in den Dolomiten

Wie kann brüchig gewordener Boden in den Dolomiten gekühlt und damit gesichert werden? Am Samstag, den 9. September fand in Cortina d'Ampezzo an der Bergstation der Sesselbahn Pian Ra Valles Bus Tofana die Präsentation des Projekts „Rescue Permafrost " statt. Ein Projekt, das in Zusammenarbeit mit Fachleuten für nachhaltiges Design, darunter einem Forschungsteam für Umweltphysik der unibz, entwickelt wurde. Das gemeinsame Ziel: das gefährliche Auftauen des Permafrosts zu verhindern, ein Phänomen, das aufgrund des globalen Klimawandels immer öfter auftritt. Die Freie Universität Bozen hat nun im Rahmen des Forschungsprojekts eine erste dynamische Analyse der Auswirkungen einer technologischen Lösung zur Kühlung der Bodentemperatur durchgeführt.

Gesunde Böden dank Partizipation der Bevölkerung: unibz koordiniert Citizen-Science-Projekt ECHO

Die Citizen-Science-Initiative „ECHO - Engaging Citizens in soil science: the road to Healthier Soils" zielt darauf ab, das Wissen und das Bewusstsein der EU-Bürger:innen für die Bodengesundheit über deren aktive Einbeziehung in das Projekt zu verbessern. Mit 16 Teilnehmern aus ganz Europa - 10 führenden Universitäten und Forschungszentren, 4 KMU und 2 Stiftungen - wird ECHO 16.500 Standorte in verschiedenen klimatischen und biogeografischen Regionen bewerten, um seine ehrgeizigen Ziele zu erreichen.

Erstversorgung: Drohnen machen den Unterschied

Die Ergebnisse einer Studie von Eurac Research und der Bergrettung Südtirol liegen vor.